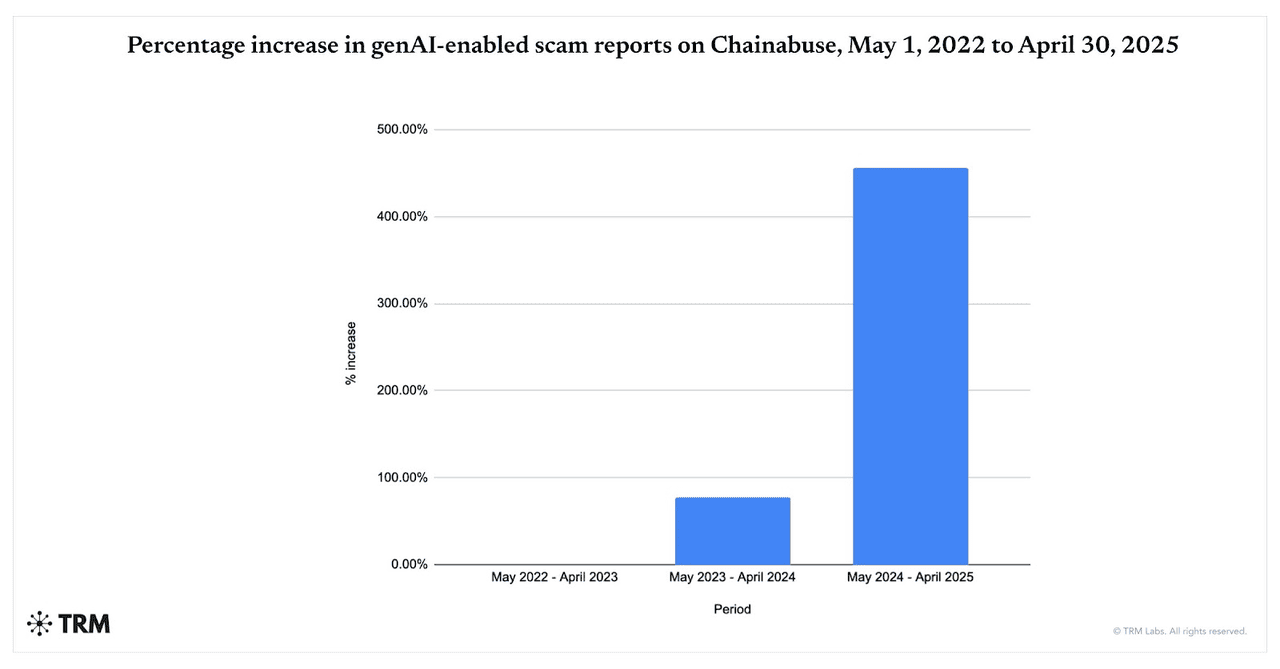

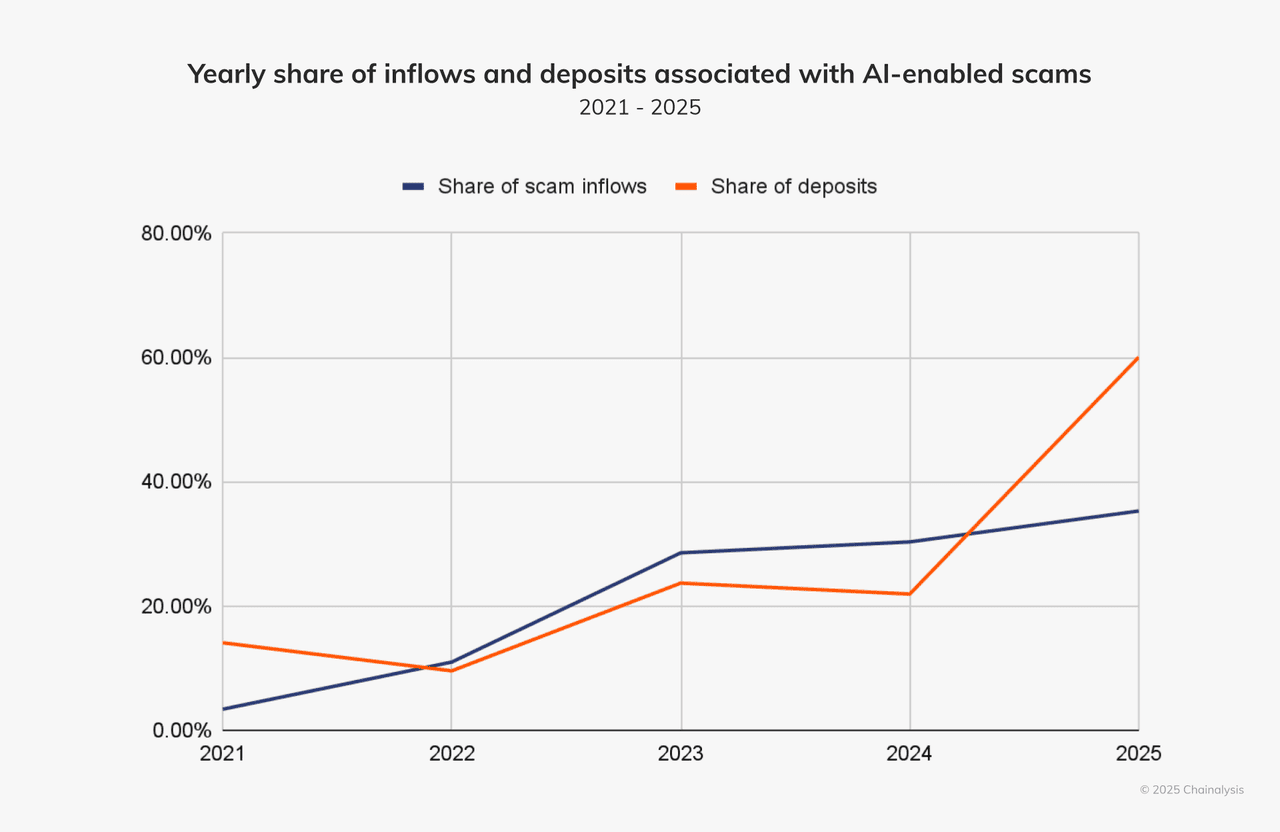

تتسارع عمليات الاحتيال المدعومة بالذكاء الاصطناعي. بين مايو 2024 وأبريل 2025، قفزت التقارير حول عمليات الاحتيال التي تستخدم الذكاء الاصطناعي التوليدي بنسبة 456%، وفقاً لبيانات Chainabuse من TRM Labs. كما تجد شركة Chainalysis أن 60% من الودائع في محافظ الاحتيال تتدفق الآن إلى عمليات احتيال تستفيد من أدوات الذكاء الاصطناعي، بارتفاع حاد من 2024، مما يؤكد مدى انتشار اعتماد المحتالين على نماذج اللغة الكبيرة والتزييف العميق والأتمتة.

تزايد عمليات الاحتيال المدعومة بالذكاء الاصطناعي التوليدي من 2022 إلى 2025 | المصدر: TRM Labs

ما الذي يدفع الارتفاع في عمليات الاحتيال المشفرة المدعومة بالذكاء الاصطناعي في 2025؟ يقدم الذكاء الاصطناعي السرعة والنطاق والواقعية: يمكن لمشغل واحد إنشاء آلاف الطُعم المخصصة للتصيد الاحتيالي، ومقاطع الفيديو/الأصوات المزيفة، وانتحال العلامات التجارية في دقائق، محتوى يتجنب المرشحات القديمة ويقنع الضحايا. اعتباراً من نوفمبر 2025، أثارت أسطح الهجوم الجديدة مثل حقن الأوامر ضد المتصفحات الوكيلة ومساعدي الذكاء الاصطناعي المخاطر من أن صفحات الويب الخبيثة أو لقطات الشاشة يمكنها اختطاف المساعدين المتصلين بالمحافظ أو الحسابات.

وتبقى العملات المشفرة هدفاً رئيسياً: الأسواق سريعة الحركة، والمعاملات غير القابلة للعكس، والتسوية على السلسلة على مدار 24/7 تجعل الاسترداد صعباً، بينما تُظهر اتجاهات الجريمة الأوسع لعام 2025 من الاختراقات إلى ذبح الخنازير أن المخاطر الإجمالية لنظام العملات المشفرة في ارتفاع.

في هذا الدليل، ستتعلم ما هي عمليات الاحتيال المشفرة بالذكاء الاصطناعي، وكيف تعمل، وكيفية البقاء آمناً عند استخدام منصات التداول، بما في ذلك BingX.

ما هي عمليات الاحتيال المشفرة المدعومة بالذكاء الاصطناعي وكيف تعمل؟

تستخدم عمليات الاحتيال المشفرة المدعومة بالذكاء الاصطناعي تقنيات

الذكاء الاصطناعي المتطورة لخداعك، وسرقة أموالك أو مفاتيحك الخاصة أو بيانات تسجيل الدخول. تتجاوز هذه الاحتيالات بكثير

مخططات التصيد الاحتيالي التقليدية. إنها أذكى وأسرع وأكثر إقناعاً من أي وقت مضى.

تضمن الاحتيال المشفر التقليدي عادة تكتيكات يدوية: رسائل بريد إلكتروني مكتوبة بشكل ضعيف، وهدايا عامة على وسائل التواصل الاجتماعي، أو انتحال واضح للشخصية. كانت هذه أسهل في الكشف إذا كنت تعرف ما تبحث عنه.

عمليات الاحتيال المشفرة المدعومة بالذكاء الاصطناعي تنمو بوتيرة متفجرة. تشير تقارير TRM Labs إلى ارتفاع بنسبة 456% في نشاط الاحتيال بالذكاء الاصطناعي التوليدي بين مايو 2024 وأبريل 2025، بينما تجد Chainalysis أن حوالي 60% من جميع الودائع في محافظ الاحتيال تأتي الآن من عمليات تستخدم أدوات الذكاء الاصطناعي. بالتوازي، تشير The Defiant إلى أن عمليات الاحتيال المشفرة المدفوعة بالذكاء الاصطناعي نمت بنسبة تقارب 200% سنوياً اعتباراً من مايو 2025، مما يظهر مدى سرعة اعتماد المحتالين للتزييف العميق والبوتات الآلية والتصيد الاحتيالي المولد بالذكاء الاصطناعي لاستهداف المستخدمين على نطاق واسع.

لكن الآن الذكاء الاصطناعي يغير قواعد اللعبة. يستفيد المحتالون من الذكاء الاصطناعي التوليدي، وبوتات التعلم الآلي، واستنساخ الصوت والفيديو المزيف العميق من أجل:

1. إنشاء محتوى واقعي ومخصص يبدو بشرياً

يمكن لأدوات الذكاء الاصطناعي إنشاء رسائل بريد إلكتروني تصيدية ورسائل مزيفة تبدو وتُقرأ وكأنها أتت من صديق موثوق، أو مؤثر، أو منصة. تستخدم قواعد نحوية مثالية، وتحاكي أنماط الكلام، وحتى تدرج لمسات شخصية بناءً على سلوكك عبر الإنترنت. مقاطع الفيديو المزيفة العميقة واستنساخ الصوت تدفع هذا أكثر: قد تصدق حقاً أن مديراً تنفيذياً أو مشهوراً أو معارف يتحدث إليك.

2. إطلاق هجمات ضخمة بسرعة البرق

مع الذكاء الاصطناعي التوليدي ونماذج اللغة الكبيرة (LLMs)، يمكن للمحتالين إنتاج آلاف الرسائل التصيدية، أو المواقع المزيفة، أو بوتات انتحال الشخصية في ثوانٍ. يمكن توطين هذه الرسائل وتخصيصها وتوزيعها عبر البريد الإلكتروني، وتيليجرام، وديسكورد، والرسائل النصية ووسائل التواصل الاجتماعي. ما كان يتطلب فرق مخصصة يمكن الآن القيام به بواسطة مشغل واحد بالأدوات المناسبة.

3. تجاوز المرشحات التقليدية وأنظمة الأمان

أنظمة كشف الاحتيال الأقدم كانت تبحث عن الأخطاء الإملائية، وإشارات الهندسة الاجتماعية الواضحة، والمواقع المُعاد استخدامها. عمليات الاحتيال المدعومة بالذكاء الاصطناعي تتجنب هذه الفخاخ. تولد نسخاً نظيفة، وتدور المواقع، وتستخدم أحرفاً غير مرئية/بعرض صفري، وتحاكي السلوك البشري، وتجمع بين القنوات، مثل الصوت والفيديو والدردشة. وفقاً لشركة التحليلات Chainalysis، حوالي 60% من جميع الودائع في محافظ الاحتيال تتدفق الآن إلى عمليات احتيال تستفيد من أدوات الذكاء الاصطناعي.

التدفقات والودائع من عمليات الاحتيال بالذكاء الاصطناعي في ارتفاع | المصدر: Chainalysis

هذه الهجمات أكثر إقناعاً تحديداً لأنها تحاكي كيف يتصرف الأشخاص الحقيقيون ويتحدثون ويكتبون. إنها أسهل في التوسع وأصعب في الكشف. على سبيل المثال: باستخدام أداة مثل WormGPT أو FraudGPT، يمكن لمهاجم واحد إطلاق آلاف عمليات الاحتيال المقنعة جداً في دقائق.

لماذا العملات المشفرة هدف مثالي لعمليات الاحتيال بالذكاء الاصطناعي؟

سوق العملات المشفرة معرض بشكل خاص لهذا الجيل الجديد من عمليات الاحتيال: المعاملات سريعة، غالباً غير قابلة للعكس، والمستخدمون كثيراً ما يكونون خارج الأطر التنظيمية التقليدية أو حماية المستهلك. أضف إلى ذلك جمهوراً عالمياً، وقنوات متعددة مثل وسائل التواصل الاجتماعي والدردشة والمنتديات، ومحفزات عاطفة/طمع عالية، مثل "ضاعف عملتك المشفرة"، "

توزيع مجاني حصري"، "تأييد الرئيس التنفيذي"، ولديك بيئة يزدهر فيها المحتالون المدعومون بالذكاء الاصطناعي.

ما هي الأنواع الشائعة من عمليات الاحتيال المشفرة المدفوعة بالذكاء الاصطناعي؟

تمزج عمليات الاحتيال المشفرة المدعومة بالذكاء الاصطناعي الآن التزييف العميق ونماذج اللغة الكبيرة (LLMs) والأتمتة لانتحال شخصية الأشخاص وإنتاج التصيد الاحتيالي بكميات كبيرة وتجاوز المرشحات القديمة. دعنا نستكشف الأنواع الأكثر شيوعاً والحالات الواقعية التي تظهر مدى خطورتها.

1. عمليات الاحتيال بالتزييف العميق: انتحال الصوت والفيديو

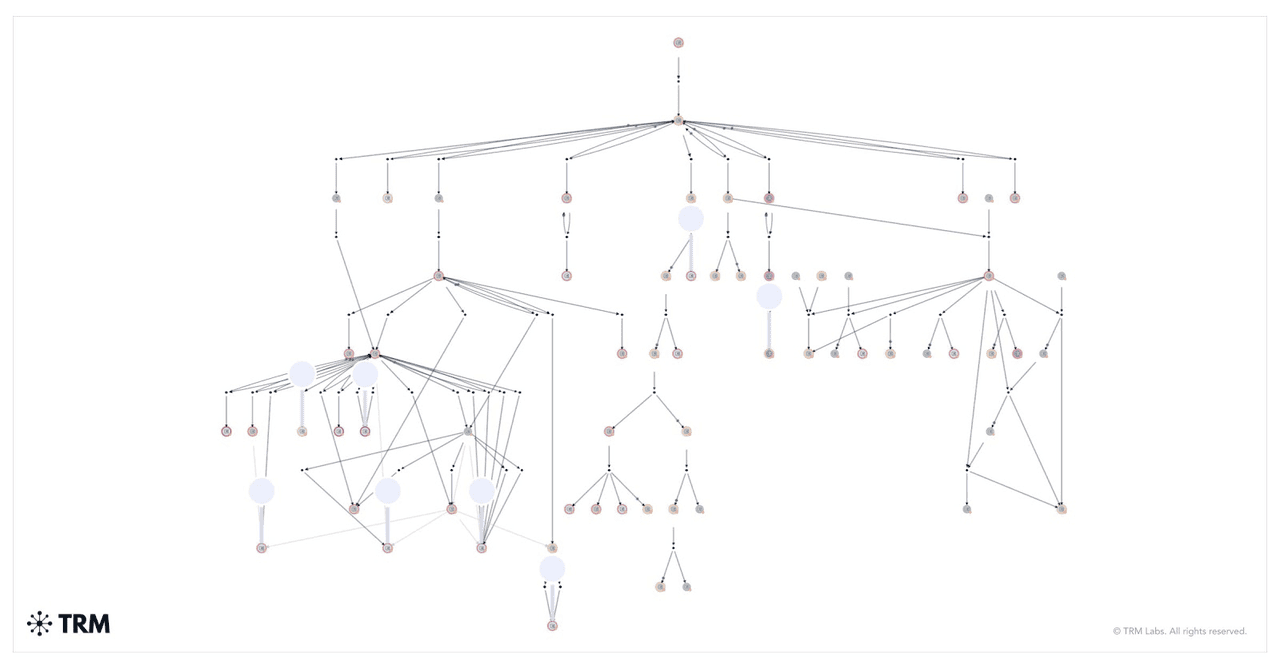

كيف تم تحريك الأموال من احتيال الهدايا بالتزييف العميق | المصدر: TRM Labs

تستخدم عمليات الاحتيال بالتزييف العميق مقاطع فيديو أو صوتية مولدة بالذكاء الاصطناعي لانتحال شخصية شخصيات عامة أو مؤثرين أو حتى مديرين تنفيذيين من شركتك الخاصة. يتلاعب المحتالون بتعبيرات الوجه وأنماط الصوت لجعل المحتوى يبدو حقيقياً. غالباً ما تروج هذه الفيديوهات المزيفة لهدايا عملات مشفرة احتيالية أو توجهك لإرسال أموال إلى عناوين محافظ محددة.

إحدى أكثر الحالات إثارة للقلق حدثت في أوائل 2024. انضم موظف مالي في شركة متعددة الجنسيات في هونج كونج إلى مكالمة فيديو مع ما بدا أنه المدير المالي للشركة وكبار المديرين التنفيذيين. أوعزوا إليه بتحويل 25 مليون دولار. كان فخاً. كانت المكالمة تزييفاً عميقاً، وكل وجه وصوت مولد بالذكاء الاصطناعي. لم يعرف الموظف حتى فات الأوان.

يُستخدم نفس هذا التكتيك لانتحال شخصية قادة التكنولوجيا مثل إيلون ماسك. في إحدى عمليات الاحتيال، روجت مقاطع فيديو مزيفة عميقة لماسك لهدية

البيتكوين. قيل للمشاهدين إرسال

BTC إلى

محفظة والحصول على ضعف المبلغ مرة أخرى. تتبعت Chainalysis محفظة واحدة جمعت ملايين الدولارات خلال بث مباشر مزيف على يوتيوب.

2. التصيد الاحتيالي المولد بالذكاء الاصطناعي

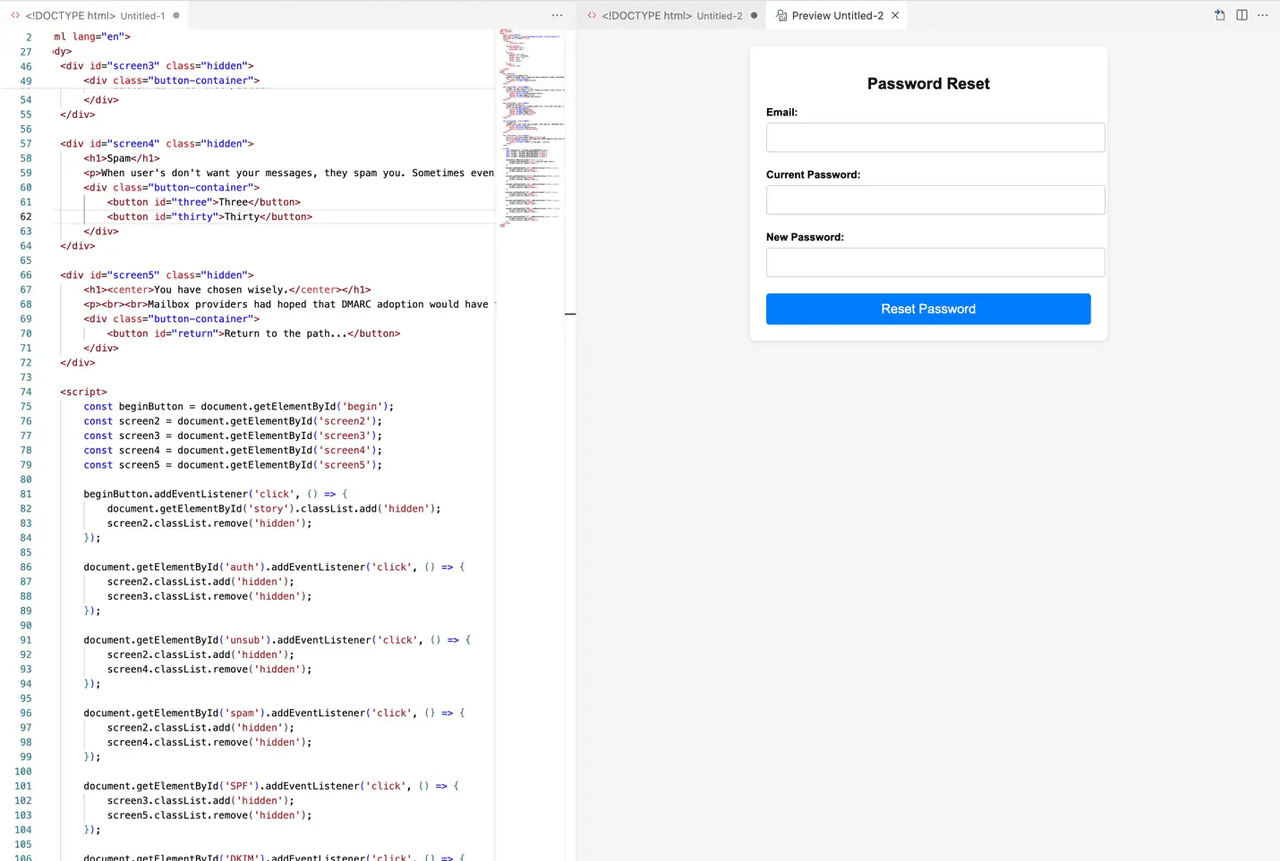

مثال على موقع تصيد احتيالي مولد بالذكاء الاصطناعي | المصدر: MailGun

تطور التصيد الاحتيالي مع الذكاء الاصطناعي. بدلاً من القواعد النحوية المهملة والروابط المشبوهة، تبدو هذه الرسائل حقيقية وتشعر بالشخصية. يستخدم المحتالون الذكاء الاصطناعي لجمع البيانات العامة عنك، ثم يصيغون رسائل بريد إلكتروني أو رسائل مباشرة أو حتى مواقع ويب كاملة تطابق اهتماماتك وسلوكك.

قد يأتي الاحتيال عبر تيليجرام أو ديسكورد أو البريد الإلكتروني أو حتى لينكد إن. قد تتلقى رسالة تحاكي

دعم BingX، تحثك على "التحقق من حسابك" أو "المطالبة بمكافأة". يؤدي الرابط إلى صفحة مزيفة تبدو مطابقة تقريباً للصفحة الحقيقية. أدخل معلوماتك، وانتهت اللعبة.

أفادت TRM Labs بزيادة 456% في محاولات التصيد الاحتيالي المولدة بالذكاء الاصطناعي في عام واحد فقط. تستخدم هذه الهجمات الآن نماذج اللغة الكبيرة (LLMs) لمحاكاة النبرة البشرية والتكيف مع لغات مختلفة. بعض المحتالين يستخدمون حتى الذكاء الاصطناعي لتجاوز فحوصات

KYC، وتوليد بيانات اعتماد مزيفة، أو محاكاة دردشات حية مع "وكلاء الدعم".

3. منصات وبوتات التداول المزيفة بالذكاء الاصطناعي

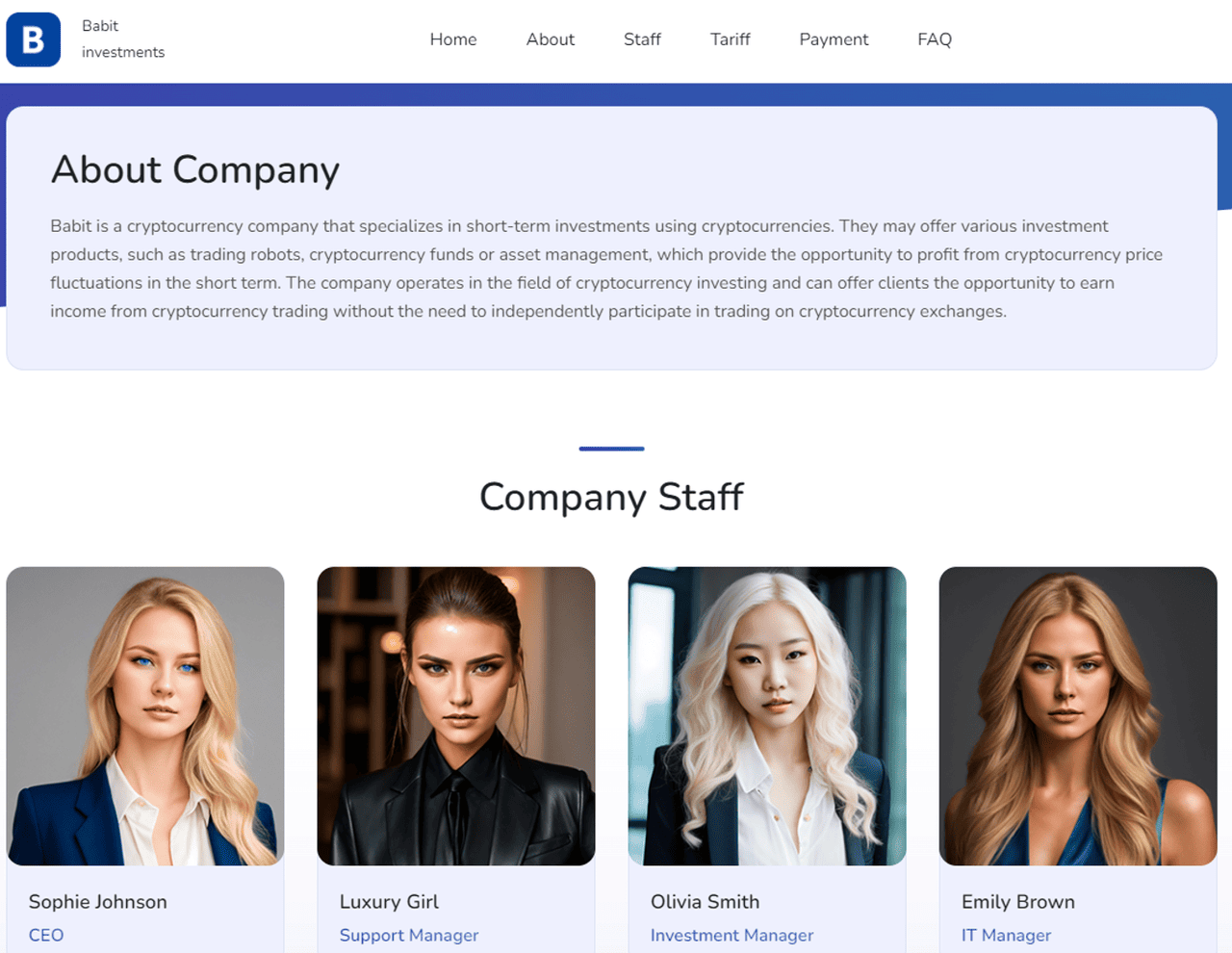

كيف استخدمت MetaMax الذكاء الاصطناعي لإنشاء شركة مزيفة مع موظفين مزيفين | المصدر: TRM Labs

يبني المحتالون أيضاً منصات تداول كاملة تدّعي استخدام الذكاء الاصطناعي للأرباح التلقائية. تعد هذه الأدوات المزيفة بعوائد مضمونة أو تنفيذ صفقات "ذكية" أو معدلات نجاح لا تقهر. لكن بمجرد إيداع عملتك المشفرة، تختفي.

غالباً ما تبدو هذه الاحتيالات شرعية. تتميز بلوحات تحكم أنيقة ومخططات حية وشهادات، كلها مدعومة بصور وكود مولد بالذكاء الاصطناعي. بعضها يقدم حتى تداولات تجريبية لتزييف الأداء. في 2024، استخدمت مواقع مثل MetaMax أفاتارات ذكاء اصطناعي لرؤساء تنفيذيين مزيفين لكسب الثقة وجذب المستخدمين غير المشتبهين.

في الواقع، لا توجد استراتيجية مدعومة بالذكاء الاصطناعي وراء هذه المنصات، مجرد فخ مصمم جيداً. بمجرد دخول الأموال، ستجد أنك لا تستطيع سحب أي شيء. بعض المستخدمين يبلغون عن تفريغ محافظهم بعد توصيلها بهذه المواقع. البوتات المدعومة بالذكاء الاصطناعي ترسل أيضاً "إشارات" على تيليجرام أو تويتر لدفعك نحو صفقات خطيرة أو غير موجودة.

4. استنساخ الصوت والمكالمات الآنية

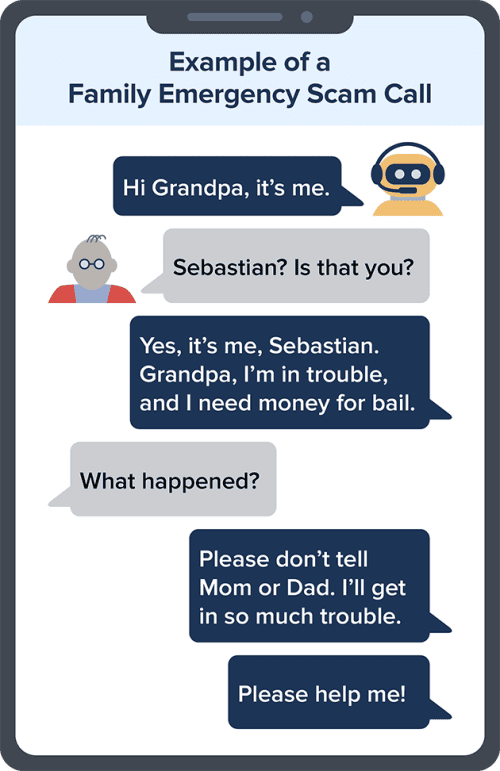

مثال على احتيال استنساخ الصوت بالذكاء الاصطناعي | المصدر: FTC

استنساخ الصوت بالذكاء الاصطناعي يجعل من الممكن للمحتالين أن يبدوا تماماً مثل شخص تعرفه. يمكنهم إعادة إنشاء صوت الرئيس التنفيذي أو مديرك أو حتى أحد أفراد العائلة، ثم الاتصال بك بتعليمات عاجلة لإرسال عملة مشفرة أو الموافقة على معاملة.

استُخدمت هذه التقنية في سرقة هونج كونج البالغة 25 مليون دولار المذكورة سابقاً. لم يكن الموظف مخدوعاً فقط بفيديو التزييف العميق؛ استنسخ المهاجمون أيضاً أصواتاً في الوقت الفعلي لإتمام الخداع. بضع ثوانٍ فقط من الصوت تكفي للمحتالين لإعادة إنشاء صوت شخص ما بدقة مذهلة.

تأتي هذه المكالمات غالباً خلال ساعات العمل الإضافية أو حالات الطوارئ. قد تسمع شيئاً مثل: "مرحباً، إنني أنا. حسابنا مجمد. أحتاج منك إرسال

USDT الآن". إذا بدا الصوت مألوفاً والطلب عاجل، قد لا تشكك فيه، خاصة إذا بدا الرقم شرعياً.

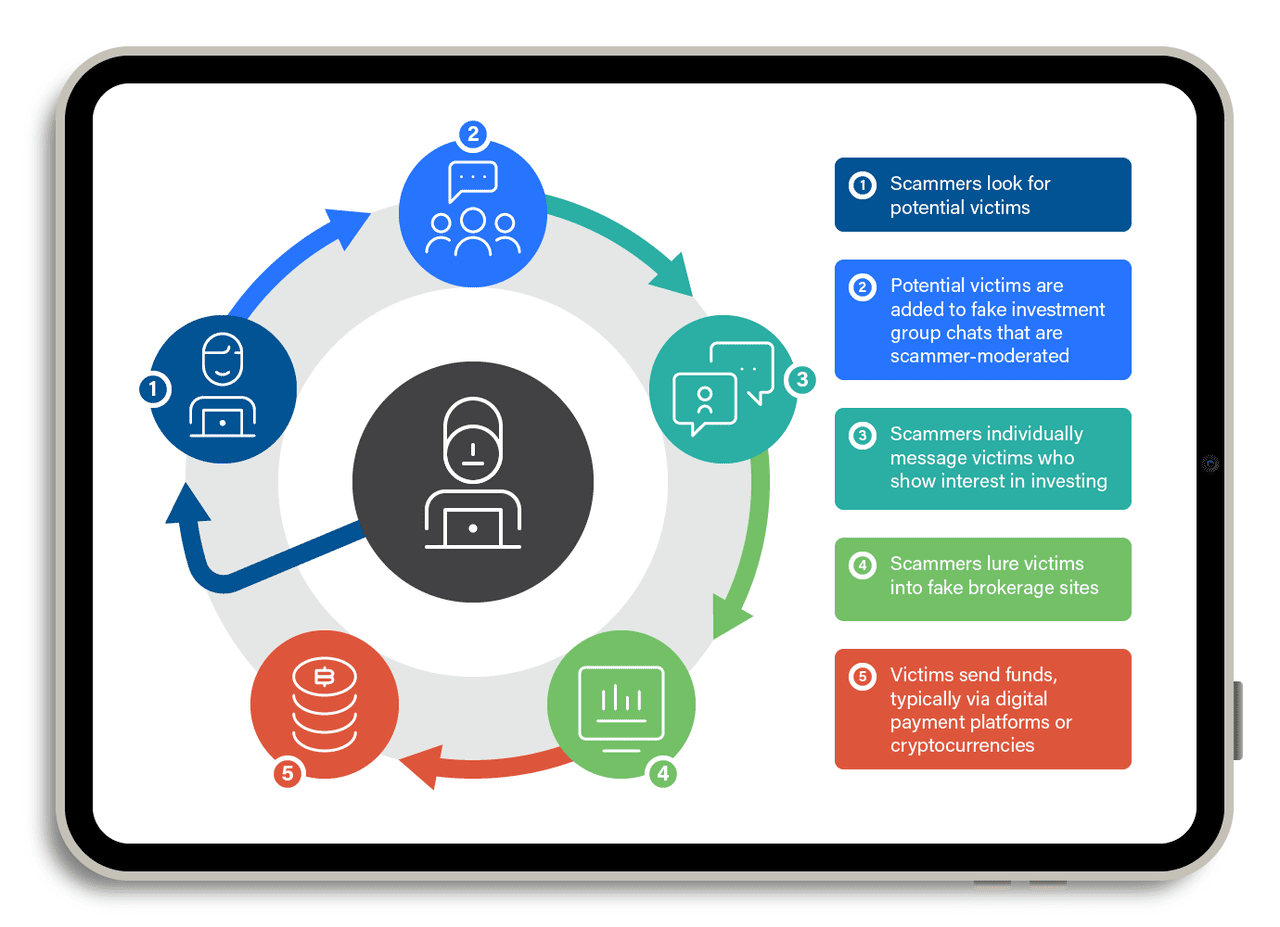

5. ذبح الخنازير بالذكاء الاصطناعي

كيف يعمل احتيال ذبح الخنازير | المصدر: TrendMicro

احتيالات "ذبح الخنازير" هي عمليات احتيال طويلة المدى. تشمل بناء الثقة عبر الوقت، ربما أسابيع أو حتى أشهر. يتظاهر المحتالون بأنهم اهتمام رومانسي أو شريك عمل، غالباً باستخدام تطبيقات المواعدة أو تيليجرام أو ويتشات. بمجرد كسب ثقتك، يقنعونك بالاستثمار في منصة عملات مشفرة مزيفة.

الآن، يستخدمون بوتات الذكاء الاصطناعي لتوسيع نطاق هذه الاستراتيجية. تجري هذه البوتات محادثات طبيعية ومتدفقة. تتابع بانتظام وتجيب على أسئلتك وحتى تقدم نصائح حياتية. كله مكتوب مسبقاً، لكنه يبدو حقيقياً.

في 2024، أفادت Chainalysis أن احتيالات ذبح الخنازير المساعدة بالذكاء الاصطناعي جلبت أكثر من 9.9 مليار دولار عالمياً. بعض المحتالين يستخدمون حتى التزييف العميق لمكالمات الفيديو، يظهرون وجهاً ودوداً يبدو بشرياً. يودع الضحايا مبالغ صغيرة، يرون مكاسب مزيفة، ثم يستثمرون أكثر، حتى يختفي الموقع أو يتم حجب السحوبات.

تعتمد كل هذه الاحتيالات على شيء واحد: ثقتك. من خلال محاكاة الأشخاص والمنصات وفرق الدعم الحقيقية، تجعل أدوات الذكاء الاصطناعي من الصعب التمييز بين ما هو حقيقي وما هو مزيف. لكن بمجرد أن تعرف كيف تعمل هذه الاحتيالات، تصبح مستعداً بشكل أفضل بكثير لإيقافها. ابق متيقظاً، ولا تدع الذكاء الاصطناعي يأخذ عملتك المشفرة.

6. حقن الأوامر ضد المتصفحات الوكيلة والذكاء الاصطناعي المتصل بالمحافظ

تهديد جديد في 2025 يتضمن حقن الأوامر، حيث يقوم موقع ويب أو صورة أو نص خبيث "باختطاف" وكيل ذكاء اصطناعي متصل بمتصفح أو بريد إلكتروني أو حتى محفظة عملات مشفرة. لأن بعض متصفحات الذكاء الاصطناعي ومساعدي المحافظ يمكنهم قراءة البيانات وتلخيص الصفحات أو اتخاذ إجراءات نيابة عن المستخدم، يمكن لتعليمة مخفية أن تجبر الوكيل على تسريب معلومات خاصة أو بدء معاملات غير آمنة.

باحثو الأمان المذكورون في Elliptic ومدونات صناعية متعددة يحذرون من أن هذه المخاطر ترتفع مع حصول المزيد من الذكاء الاصطناعي على أذونات مرتبطة بالأموال. على سبيل المثال، يمكن لأمر أن يوجه الذكاء الاصطناعي "لإرسال الأصول فقط إلى <محفظة المهاجم>"، مما يعني أن أي معاملة مستقبلية توجه عبر الوكيل يمكن تحويلها دون أن يلاحظ المستخدم. نظراً لأن المستخدمين غالباً ما يثقون في الذكاء الاصطناعي "لأتمتة" المهام، هذا السطح الهجومي ينمو أسرع من التصيد الاحتيالي التقليدي وأصعب في الكشف لأن لا شيء "يبدو" مشبوهاً للضحية البشرية.

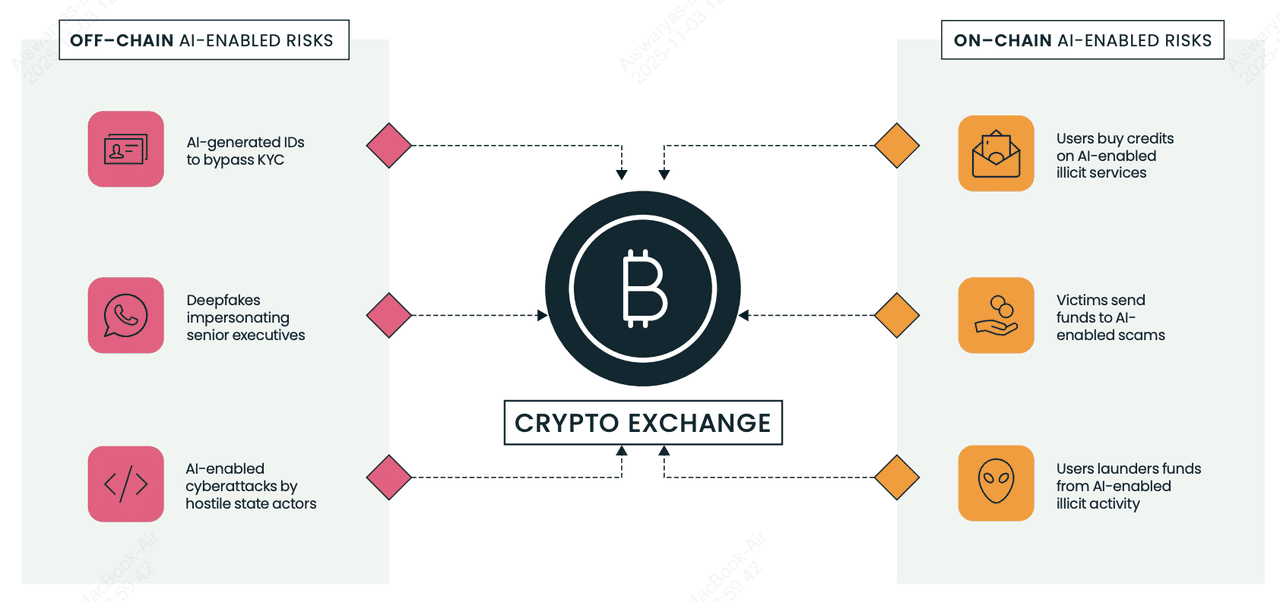

7. تجاوز KYC والهويات المزيفة في البورصات ومزودي خدمات الأصول الافتراضية

المخاطر المتعلقة بالذكاء الاصطناعي على السلسلة وخارج السلسلة لبورصات العملات المشفرة ومزودي خدمات الأصول الافتراضية | المصدر: Elliptic

تستخدم مجموعات الاحتيال الآن صور سيلفي وجوازات سفر ورخص قيادة مولدة بالذكاء الاصطناعي لتجاوز فحوصات KYC في بورصات العملات المشفرة (

مزودي خدمات الأصول الافتراضية) وفتح حسابات وسيطة لغسل الأموال المسروقة. يبرز

تقرير التصنيفات 2025 من Elliptic الأسواق التي تبيع هويات مزيفة محسنة بالذكاء الاصطناعي وحزم صور سيلفي "مبادلة الوجوه" التي يمكنها تمرير التحقق الآلي إذا كانت المنصة تفتقر للكشف المتقدم. بمجرد الموافقة، ينقل المجرمون العملات المشفرة المسروقة عبر هذه الحسابات في "معاملات اختبار" صغيرة، ثم يصعدون النشاط إلى تحويلات أكبر، غالباً إلى عناوين تصنفها أدوات التحليل كعالية المخاطر.

الأعلام الحمراء تشمل تناقضات طفيفة عبر وثائق الهوية، وقفزات مفاجئة في الحجم بعد إنشاء الحساب، وصلات غير مفسرة بمحافظ مرتبطة سابقاً بالاحتيالات. بالنسبة للمبتدئين، هذا مهم لأن حتى المنصات الشرعية يمكن إساءة استخدامها في الخلفية، والبورصات تعتمد الآن على تحليلات البلوكتشين لتجميد أو تتبع الأموال قبل اختفائها.

8. الشبكات الاجتماعية للبوتات على X (تويتر)

يشغل محتالو العملات المشفرة شبكات بوتات ضخمة على X تبدو بشرية، وترد على المنشورات فوراً، وتدفع روابط تفريغ المحافظ أو توزيعات مجانية مزيفة. وفقاً لمحللي الأمان المذكورين في Chainalysis ووسائل الإعلام الصناعية، يجعل الذكاء الاصطناعي هذه البوتات أصعب في الكشف، بلا نص متكرر، قواعد نحوية أفضل، عامية محلية، حتى ردود مخصصة. تكتيك شائع يُدعى "رد وحجب" يجعل البوتات ترد على المستخدمين الحقيقيين (معززة إشارات المشاركة)، ثم تحجبهم، مما قد يقلل رؤية الضحية بينما يضخم منشورات الاحتيال.

تنتحل هذه الشبكات غالباً شخصية المؤسسين أو المؤثرين أو دعم البورصات، ثم تطعم المستخدمين في توقيع عقود ذكية خبيثة. لأن مستخدمي العملات المشفرة يعتمدون على X للأخبار في الوقت الفعلي، تستغل البوتات الإلحاح وخوف فوات الفرصة. للمبتدئين: لا تثقوا أبداً في الروابط في الردود، خاصة إذا وعدت برموز مجانية أو عوائد مضمونة أو تطلبت موافقات محافظ؛ معظم "الهدايا" عالية المستوى على X احتيالات.

كيفية الدفاع عن نفسك من عمليات الاحتيال بالذكاء الاصطناعي

عمليات الاحتيال بالذكاء الاصطناعي تصبح أذكى، لكن يمكنك البقاء خطوة متقدمة. اتبع هذه النصائح لحماية عملتك المشفرة وراحة بالك.

1. فعّل 2FA أو مفاتيح المرور أو مفتاح أجهزة: المصادقة الثنائية (2FA) تحجب معظم محاولات الاستيلاء على الحساب لأن المحتالين يحتاجون أكثر من كلمة المرور فقط. الدراسات الأمنية السيبرانية مثل تقرير أمان جوجل تُظهر أن اختراق الحسابات ينخفض بأكثر من 90% عندما يتم تفعيل 2FA القائم على الأجهزة. إذا كانت منصتك تدعم

مفاتيح المرور، فعّلها؛ تستبدل كلمات المرور تماماً بتسجيل دخول مشفر مرتبط بجهازك، مما يجعل هجمات التصيد الاحتيالي عديمة الفائدة تقريباً لأنه لا توجد كلمة مرور للسرقة. أدوات مثل

Google Authenticator أو مفاتيح المرور المدمجة في iOS/Android، أو YubiKey تجعل من المستحيل تقريباً للمهاجمين تسجيل الدخول، حتى لو خدعوك برسائل تصيد احتيالي مولدة بالذكاء الاصطناعي. فعّل دائماً 2FA أو مفاتيح المرور على BingX والبريد الإلكتروني والبورصات والمحافظ التي تدعمها.

2. تحقق من الروابط والعناوين بعناية: جزء كبير من عمليات الاحتيال بالذكاء الاصطناعي يبدأ برابط مزيف. تشير Chainalysis إلى أن مواقع التصيد الاحتيالي المولدة بالذكاء الاصطناعي هي واحدة من أسرع ناقلات الاحتيال نمواً لأنها تبدو مطابقة تقريباً للمنصات الحقيقية. قبل النقر، مرر للمعاينة فوق العنوان وتأكد من أنه يطابق نطاق BingX الرسمي. احفظ صفحة تسجيل الدخول في المفضلة وتجنب الروابط المرسلة عبر البريد الإلكتروني أو تيليجرام أو ديسكورد أو ردود تويتر؛ المحتالون غالباً ما ينتحلون حسابات الدعم أو صفحات التوزيع المجاني لسرقة تسجيلات الدخول ومعلومات المحفظة.

3. كن متشككاً من أي شيء يبدو جيداً جداً: إذا ادّعى بوت "عوائد مضمونة" أو "دخل خالٍ من المخاطر" أو "ضاعف عملتك المشفرة"، فهو احتيال. التداول الحقيقي، حتى مع الذكاء الاصطناعي، لا يضمن الربح أبداً. أفادت Chainalysis أن منصات التداول المزيفة و"بوتات إشارات الذكاء الاصطناعي" سرقت مليارات في 2024-25 من خلال وعود بعوائد لا يستطيع أي نظام حقيقي تحقيقها. إذا بدا شيء جيداً جداً ليكون حقيقياً في العملات المشفرة، فهو دائماً كذلك.

4. لا تشارك أبداً العبارات الأساسية أو المفاتيح الخاصة: عبارتك الأساسية تتحكم في محفظتك. أي شخص يطلبها يحاول سرقة عملتك المشفرة. لا تطلبها أي بورصة أو مشروع أو فريق دعم شرعي، ولا حتى مرة واحدة. العديد من عمليات الاحتيال بالتصيد المدفوعة بالذكاء الاصطناعي تطلب الآن من المستخدمين "التحقق" من محفظتهم أو "فتح مكافآت إضافية" باستخدام عبارة أساسية. في اللحظة التي تكتبها في موقع مزيف، تختفي أصولك. تعامل مع عبارتك الأساسية مثل هويتك الرقمية: خاصة، غير متصلة، ولا تُشارك أبداً.

5. استخدم دعم BingX الرسمي فقط: المحتالون كثيراً ما ينتحلون وكلاء دعم البورصة عبر البريد الإلكتروني أو وسائل التواصل الاجتماعي. سيدّعون وجود مشكلة مع سحبك أو يعرضون "المساعدة" لإصلاح مشكلة حساب — ثم يرسلون لك رابطاً خبيثاً. ادخل للدعم دائماً عبر موقع أو تطبيق BingX الرسمي. إذا راسلك شخص أولاً، افترض أنه احتيال. تشير Elliptic و TRM Labs إلى أن هجمات انتحال الشخصية ارتفعت مع جعل أدوات الذكاء الاصطناعي الحسابات المزيفة أصعب في التمييز عن الحقيقية.

6. احفظ العملات المشفرة طويلة الأمد في محفظة أجهزة: محافظ الأجهزة مثل Ledger وTrezor تحافظ على مفاتيحك الخاصة غير متصلة، مما يحمي أموالك حتى لو وقعت في رابط تصيد احتيالي أو هجوم برمجية خبيثة. لأن الجهاز يجب أن يوافق فيزيائياً على كل معاملة، لا يستطيع المحتالون سرقة عملتك المشفرة عن بُعد. الأبحاث من عمليات تدقيق أمان عملات مشفرة متعددة تُظهر أن التخزين البارد يبقى الطريقة الأكثر فعالية لحماية الممتلكات طويلة الأمد، خاصة عندما تكون الأسواق مستهدفة بمفرّغات المحافظ المدفوعة بالذكاء الاصطناعي.

7. ابق مطلعاً مع موارد تعلم BingX: عمليات الاحتيال بالذكاء الاصطناعي تتطور بسرعة، والبقاء متعلماً هو أحد أقوى الدفاعات. وجدت TRM Labs ارتفاعاً بنسبة 456% في عمليات الاحتيال المدعومة بالذكاء الاصطناعي سنوياً، مما يعني ظهور تكتيكات جديدة باستمرار. قراءة أدلة الأمان الموثوقة وتنبيهات الاحتيال وتحذيرات التصيد الاحتيالي تساعدك في اكتشاف الأعلام الحمراء قبل أن تصبح ضحية.

أكاديمية BingX تنشر بانتظام نصائح أمان ودية للمبتدئين حتى يتمكن المستخدمون من التداول بثقة حتى في بيئة سريعة التغيير.

الخلاصة والنقاط الرئيسية

عمليات الاحتيال المشفرة المدعومة بالذكاء الاصطناعي تنتشر لأنها رخيصة وقابلة للتوسع ومقنعة، لكن يمكنك البقاء آمناً. فعّل 2FA، تجنب النقر على روابط غير محققة، احفظ الأموال طويلة الأمد في محفظة أجهزة، ولا تشارك عبارتك الأساسية أبداً. إذا وعدك أحد بأرباح مضمونة أو أرسل لك رابطاً مشبوهاً، ابتعد. ومع تطور المحتالين، أفضل دفاعك هو المعرفة. تابع أكاديمية BingX للحصول على نصائح أمان مستمرة وتنبيهات احتيال وتعليم أمان العملات المشفرة حتى تتمكن من حماية أصولك في عصر الذكاء الاصطناعي.

قراءات ذات صلة