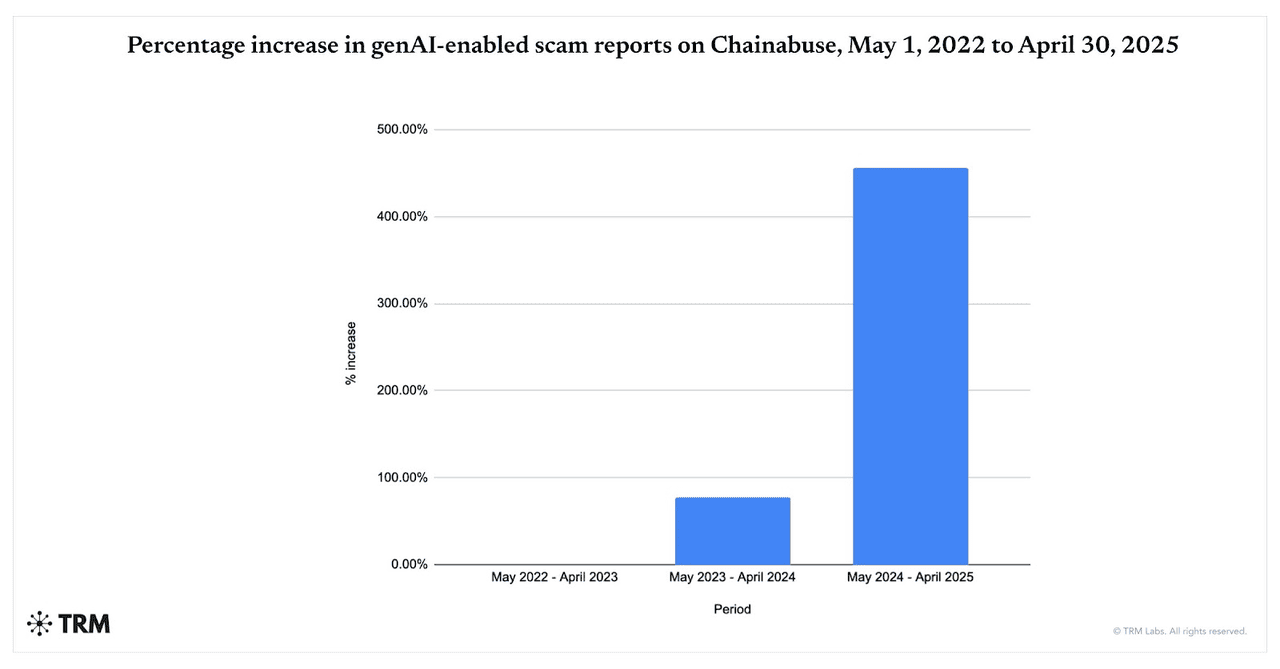

Oszustwa wspierane przez AI przyspieszają. Między majem 2024 a kwietniem 2025 roku zgłoszenia oszustw wykorzystujących gen-AI wzrosły o 456%, według danych Chainabuse od TRM Labs. Chainalysis stwierdza również, że 60% wpłat do portfeli oszustów obecnie płynie do oszustw wykorzystujących narzędzia AI, co stanowi gwałtowny wzrost w stosunku do 2024 roku, podkreślając jak szeroko oszuści przyjmują LLM, deepfaki i automatyzację.

Oszustwa wykorzystujące sztuczną inteligencję gwałtownie rosną od 2022 do 2025 roku | Źródło: TRM Labs

Co napędza wzrost oszustw kryptowalutowych wspieranych przez AI w 2025 roku? AI zapewnia szybkość, skalę i realizm: jeden operator może w ciągu minut stworzyć tysiące dostosowanych przynęt phishingowych, filmów/głosów deepfake oraz imitacji marek, treści które omijają starsze filtry i przekonują ofiary. Od listopada 2025 roku nowe powierzchnie ataku, takie jak wstrzykiwanie promptów przeciwko przeglądarkom agentowym i współpilotom AI, zwiększyły ryzyko, że złośliwe strony internetowe lub zrzuty ekranu mogą przejąć asystentów połączonych z portfelami lub kontami.

Kryptowaluty pozostają głównym celem: szybko zmieniające się rynki, nieodwracalne transakcje i 24/7 rozliczenia on-chain utrudniają odzyskanie środków, podczas gdy szersze trendy przestępczości w 2025 roku, od ataków po pig-butchering, pokazują rosnące ogólne ryzyko w ekosystemie kryptowalutowym.

W tym przewodniku dowiesz się, czym są kryptowalutowe oszustwa AI, jak działają i jak zachować bezpieczeństwo podczas korzystania z platform handlowych, w tym BingX.

Czym są kryptowalutowe oszustwa wspierane przez AI i jak działają?

Kryptowalutowe oszustwa wspierane przez AI wykorzystują zaawansowane techniki

sztucznej inteligencji, aby Cię oszukać, kradnąc Twoje pieniądze, klucze prywatne lub dane logowania. Te oszustwa wykraczają daleko poza stare

schematy phishingowe. Są mądrzejsze, szybsze i znacznie bardziej wiarygodne niż kiedykolwiek wcześniej.

Tradycyjne oszustwa kryptowalutowe zazwyczaj obejmowały manualne taktyki: źle napisane e-maile, ogólne rozdawnictwa w mediach społecznościowych lub oczywiste podszywanie się. Było je łatwiej rozpoznać, jeśli wiedziało się, na co zwracać uwagę.

Kryptowalutowe oszustwa wspierane przez AI rosną w eksplozywnym tempie. TRM Labs raportuje 456% wzrost aktywności oszustw z generatywną AI między majem 2024 a kwietniem 2025 roku, podczas gdy Chainalysis stwierdza, że około 60% wszystkich wpłat do portfeli oszustów pochodzi obecnie z operacji wykorzystujących narzędzia AI. Równolegle The Defiant zauważa, że oszustwa kryptowalutowe napędzane przez AI wzrosły o prawie 200% rok do roku od maja 2025 roku, pokazując jak szybko oszuści przyjmują deepfaki, automatyczne boty i generowane przez AI phishing do atakowania użytkowników na skalę.

Ale teraz AI zmienia zasady gry. Oszuści wykorzystują generatywną AI, boty uczenia maszynowego, klonowanie głosu i deepfake video do:

1. Tworzenia realistycznych i spersonalizowanych treści, które wydają się ludzkie

Narzędzia AI mogą generować phishingowe e-maile i fałszywe wiadomości, które brzmią i czytają się jak pochodzące od zaufanego przyjaciela, influencera lub platformy. Używają bezbłędnej gramatyki, naśladują wzorce mowy, a nawet wstawiają osobiste akcenty oparte na Twoim zachowaniu online. Filmy deepfake i klony głosu posuwają to dalej: możesz naprawdę uwierzyć, że CEO, celebryta lub znajomy mówi do Ciebie.

2. Przeprowadzania masowych ataków z błyskawiczną szybkością

Dzięki generatywnej AI i dużym modelom językowym (LLM), oszuści mogą w sekundach wyprodukować tysiące wiadomości phishingowych, fałszywych stron internetowych lub botów imitujących. Te wiadomości mogą być lokalizowane, personalizowane, dystrybuowane przez e-mail, Telegram, Discord, SMS i media społecznościowe. To, co kiedyś wymagało dedykowanych zespołów, może teraz zostać wykonane przez jednego operatora z odpowiednimi narzędziami.

3. Omijania tradycyjnych filtrów i systemów bezpieczeństwa

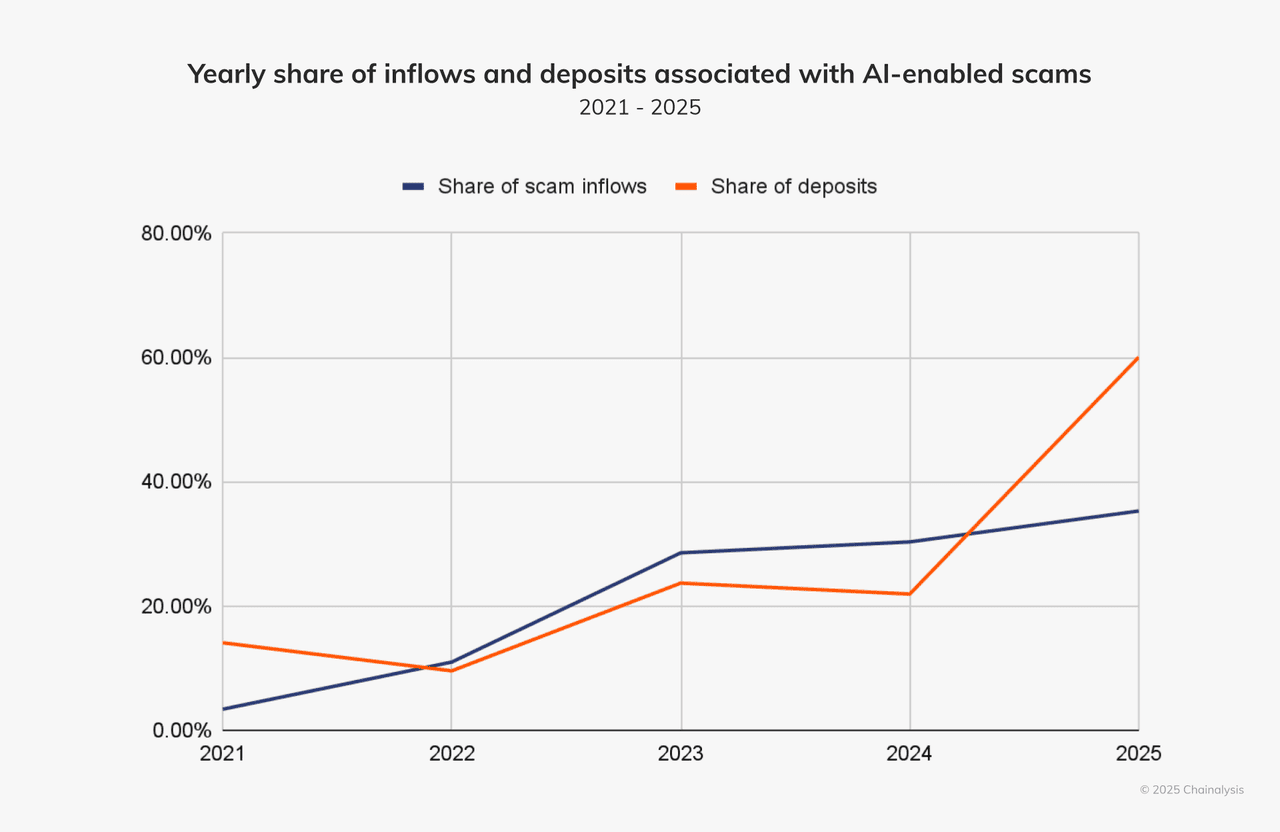

Starsze systemy wykrywania oszustw szukały błędów ortograficznych, oczywistych sygnałów inżynierii społecznej, ponownie używanych domen. Oszustwa wspierane przez AI unikają tych pułapek. Generują czyste treści, rotują domeny, używają niewidocznych/zero-width znaków, naśladują ludzkie zachowanie i łączą kanały, takie jak głos, wideo i czat. Według firmy analitycznej Chainalysis, około 60% wszystkich wpłat do portfeli oszustów płynie obecnie do oszustw wykorzystujących narzędzia AI.

Napływy i wpłaty z oszustw AI są w wzroście | Źródło: Chainalysis

Te ataki są bardziej przekonujące właśnie dlatego, że naśladują sposób, w jaki prawdziwi ludzie się zachowują, mówią i piszą. Są łatwiejsze do skalowania i trudniejsze do wykrycia. Na przykład: używając narzędzia takiego jak WormGPT lub FraudGPT, jeden napastnik może w minuty uruchomić tysiące bardzo wiarygodnych oszustw.

Dlaczego krypto jest idealnym celem dla oszustw AI?

Rynek kryptowalutowy jest szczególnie narażony na tę nową generację oszustw: transakcje są szybkie, często nieodwracalne, a użytkownicy często znajdują się poza tradycyjnymi ramami regulacyjnymi lub ochrony konsumentów. Dodaj globalną publiczność, wiele kanałów takich jak social, czat, fora i wysokie bodźce emocjonalne/chciwości, np. „podwój swoje krypto", „ekskluzywny

airdrop", „poparcie CEO", a masz środowisko, w którym oszuści wspierani przez AI prosperują.

Jakie są powszechne typy kryptowalutowych oszustw napędzanych przez AI?

Kryptowalutowe oszustwa wspierane przez AI teraz łączą deepfaki, duże modele językowe (LLM) i automatyzację, aby podszywać się pod ludzi, masowo produkować phishing i omijać starsze filtry. Przeanalizujmy najpowszechniejsze typy i rzeczywiste przypadki, które pokazują, jak niebezpieczne się stały.

1. Oszustwa deepfake: podszywanie się pod dźwięk i wideo

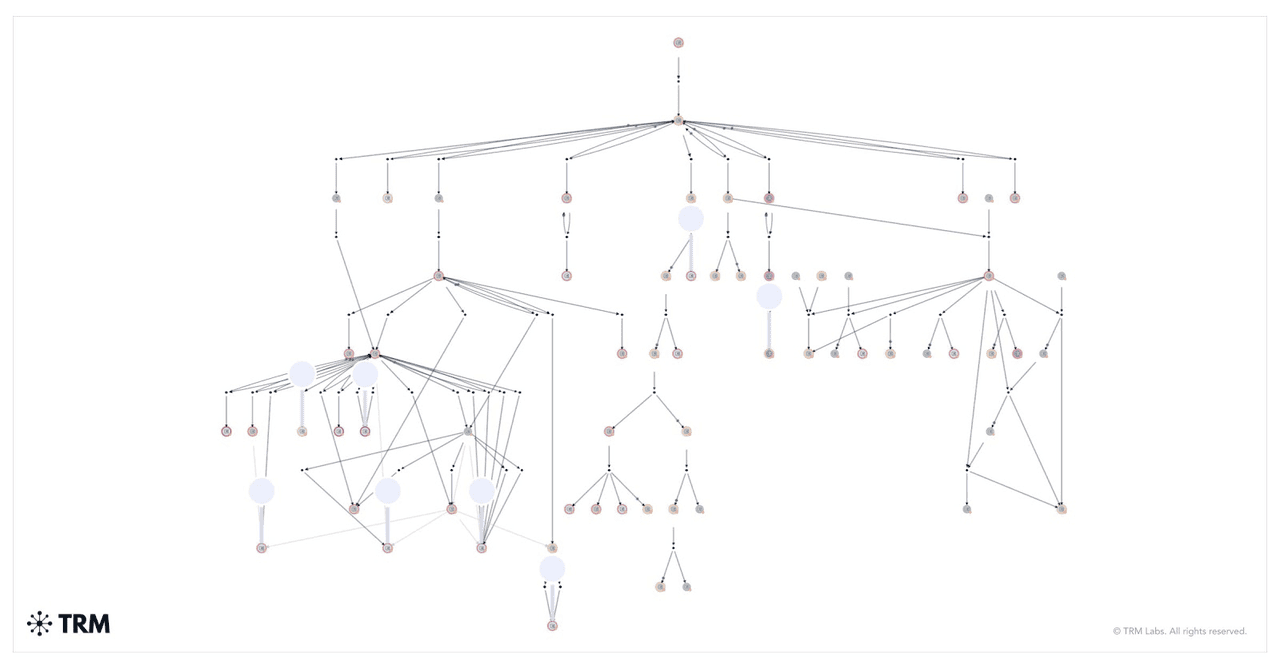

Jak środki z oszustwa rozdawniczego deepfake zostały przeniesione | Źródło: TRM Labs

Oszustwa deepfake wykorzystują generowane przez AI filmy lub klipy audio do podszywania się pod osoby publiczne, influencerów, a nawet dyrektorów z Twojej własnej firmy. Oszuści manipulują wyrazami twarzy i wzorcami głosu, aby treść wydawała się prawdziwa. Te fałszywe filmy często promują oszukańcze rozdawnictwa krypto lub instruują, aby wysłać środki na określone adresy portfeli.

Jeden z najbardziej alarmujących przypadków miał miejsce na początku 2024 roku. Pracownik finansowy w międzynarodowej firmie w Hongkongu dołączył do wideokonferencji z tym, co wydawało się być CFO firmy i starszymi dyrektorami. Poinstruowali go, aby przelał 25 milionów dolarów. To była pułapka. Rozmowa była deepfake'iem, a każda twarz i głos zostały wygenerowane przez AI. Pracownik nie wiedział, dopóki nie było już za późno.

Ta sama taktyka jest używana do podszywania się pod liderów technologicznych takich jak Elon Musk. W jednym oszustwie filmy deepfake Muska promowały rozdawnictwo

Bitcoin. Widzowie byli poproszeni o wysłanie

BTC do

portfela i otrzymanie podwójnej kwoty z powrotem. Chainalysis śledził pojedynczy portfel, który zebrał miliony dolarów podczas fałszywego livestreamu na YouTube.

2. Phishing generowany przez AI

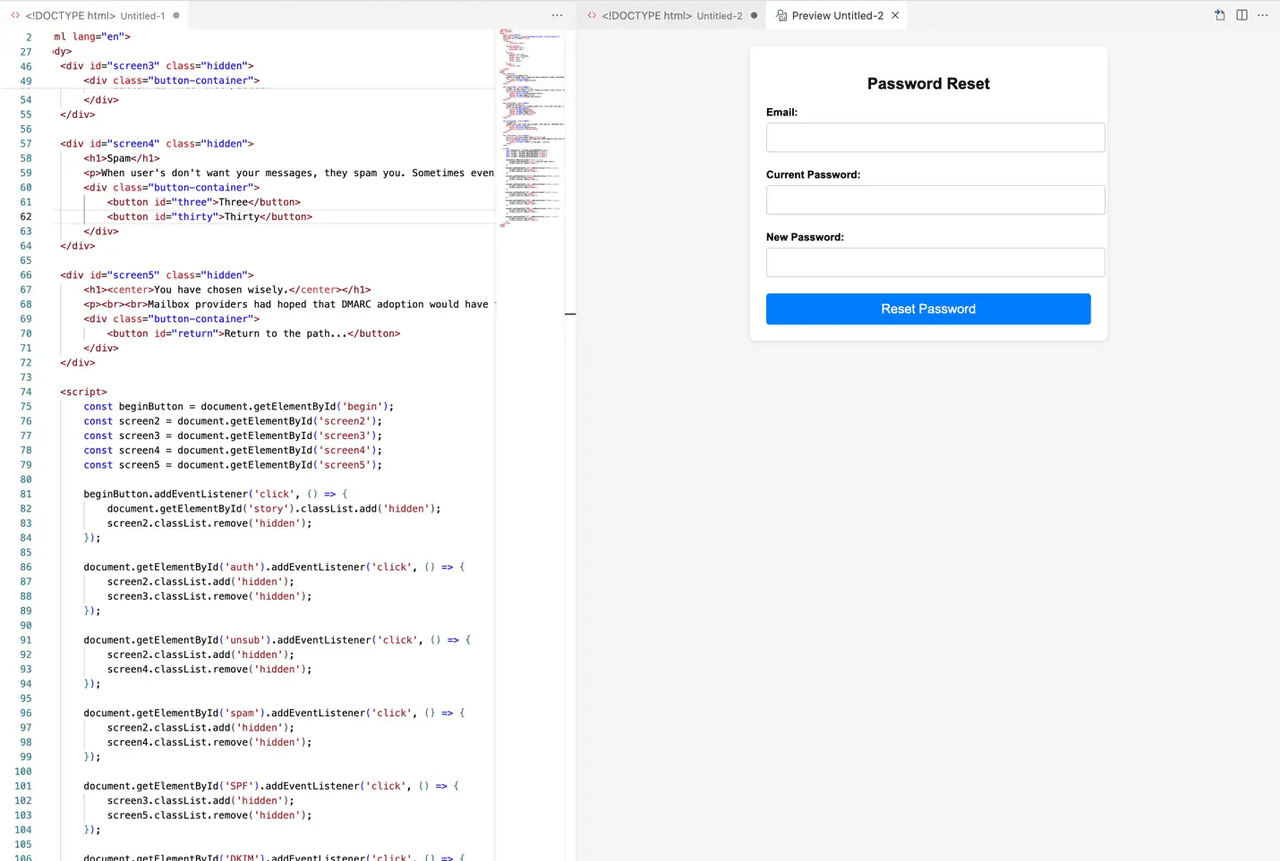

Przykład strony phishingowej generowanej przez AI | Źródło: MailGun

Phishing ewoluował dzięki AI. Zamiast niechlujnej gramatyki i podejrzanych linków, te wiadomości wyglądają prawdziwie i są osobiste. Oszuści wykorzystują AI do zbierania publicznych danych o Tobie, następnie tworzą e-maile, wiadomości prywatne, a nawet całe strony internetowe, które pasują do Twoich zainteresowań i zachowania.

Oszustwo może nadejść przez Telegram, Discord, e-mail, a nawet LinkedIn. Możesz otrzymać wiadomość naśladującą

wsparcie BingX, naglącą Cię do „zweryfikowania konta" lub „odebrania nagrody". Link prowadzi do fałszywej strony, która wygląda niemal identycznie jak prawdziwa. Wprowadź swoje dane, a to koniec gry.

TRM Labs raportował 456% wzrost prób phishingu generowanego przez AI w ciągu zaledwie jednego roku. Te ataki teraz używają dużych modeli językowych (LLM) do naśladowania ludzkiego tonu i adaptacji do różnych języków. Niektórzy oszuści nawet używają AI do omijania kontroli

KYC, generowania fałszywych danych uwierzytelniających lub symulowania live czatów z „agentami wsparcia".

3. Fałszywe platformy handlowe AI i boty

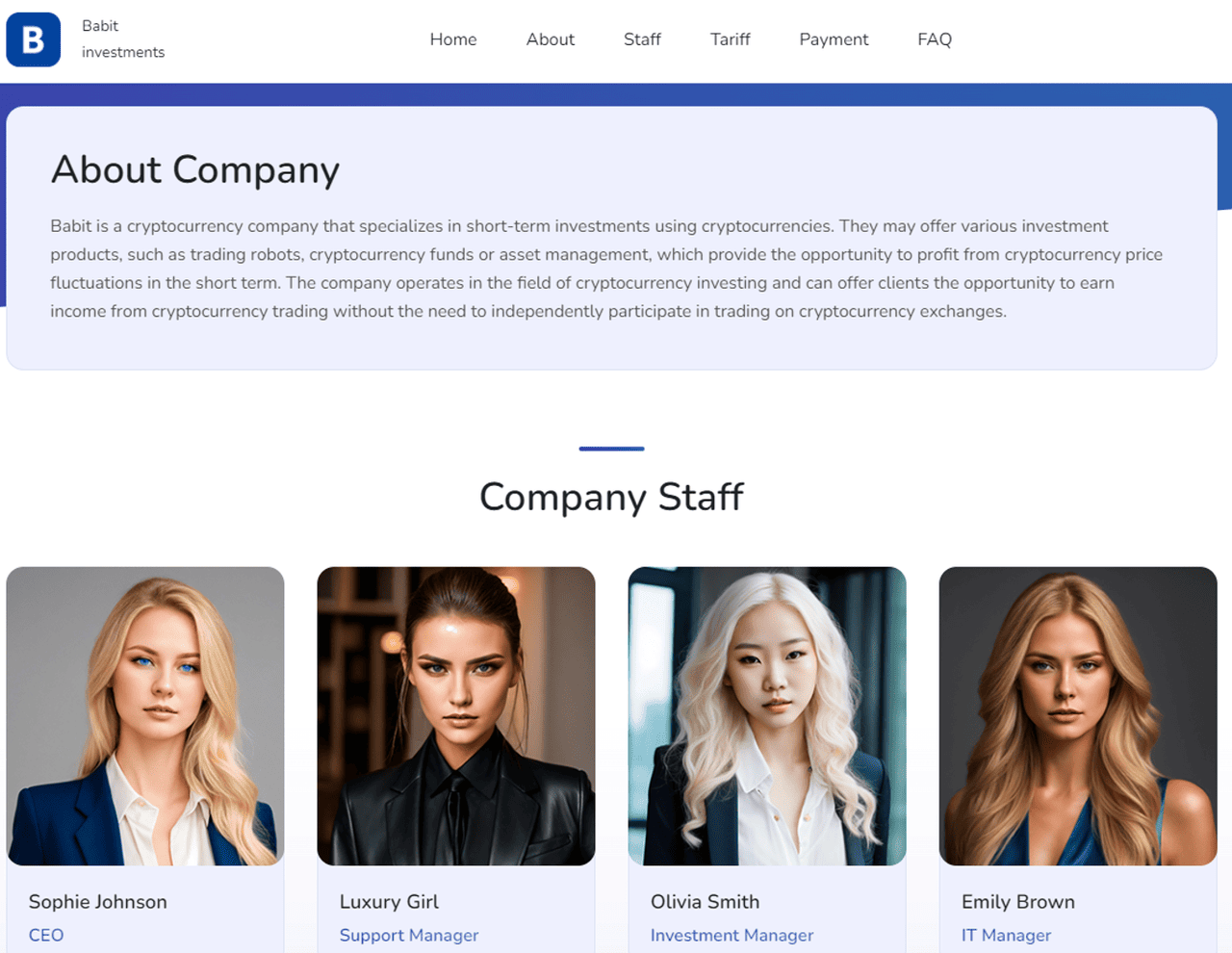

Jak MetaMax użył AI do stworzenia fałszywej firmy z fałszywymi pracownikami | Źródło: TRM Labs

Oszuści budują również całe platformy handlowe, które twierdzą, że używają AI do automatycznych zysków. Te fałszywe narzędzia obiecują gwarantowane zwroty, „inteligentną" realizację transakcji lub niezwyciężone wskaźniki sukcesu. Ale gdy wpłacisz swoje krypto, ono znika.

Te oszustwa często wyglądają legalnie. Mają eleganckie panele kontrolne, live wykresy i testimoniale, wszystko wspierane przez generowane przez AI obrazy i kod. Niektóre nawet oferują demo transakcji, aby sfałszować wyniki. W 2024 roku strony takie jak MetaMax używały awatarów AI fałszywych CEO, aby zdobyć zaufanie i przyciągnąć niczego niepodejrzewających użytkowników.

W rzeczywistości nie ma żadnej strategii wspieranej przez AI za tymi platformami, tylko dobrze zaprojektowana pułapka. Gdy środki wejdą, okaże się, że nie można nic wypłacić. Niektórzy użytkownicy zgłaszają, że ich portfele zostały opróżnione po podłączeniu ich do tych stron. Boty AI również wysyłają „sygnały" na Telegramie lub Twitterze, aby popchnąć Cię ku ryzykownym lub nieistniejącym transakcjom.

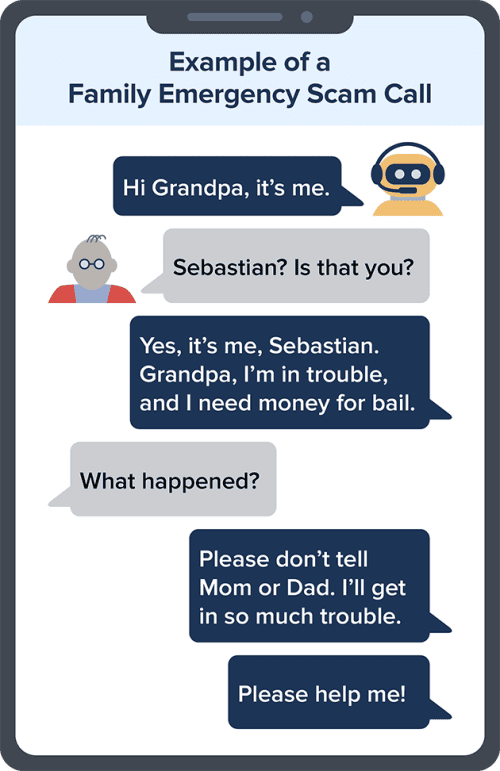

4. Klonowanie głosu i rozmowy w czasie rzeczywistym

Przykład oszustwa klonowania głosu AI | Źródło: FTC

Klonowanie głosu AI umożliwia oszustom brzmienie dokładnie jak ktoś, kogo znasz. Mogą odtworzyć głos CEO, Twojego menedżera, a nawet członka rodziny, następnie zadzwonić do Ciebie z pilnymi instrukcjami, aby wysłać krypto lub zatwierdzić transakcję.

Ta technika została użyta w kradzieży 25 milionów dolarów w Hongkongu wspomnianej wcześniej. Pracownik nie został tylko oszukany przez deepfake video; napastnicy również sklonowali głosy w czasie rzeczywistym, aby przypieczętować oszustwo. Zaledwie kilka sekund nagrania audio wystarczy oszustom do odtworzenia czyjegośł głosu z szokującą dokładnością.

Te telefony często przychodzą poza godzinami pracy lub w nagłych wypadkach. Możesz usłyszeć coś takiego: „Hej, to ja. Nasze konto jest zamrożone. Muszę, żebyś teraz wysłał

USDT." Jeśli głos brzmi znajomo, a prośba jest pilna, możesz tego nie kwestionować, szczególnie jeśli numer wydaje się legalny.

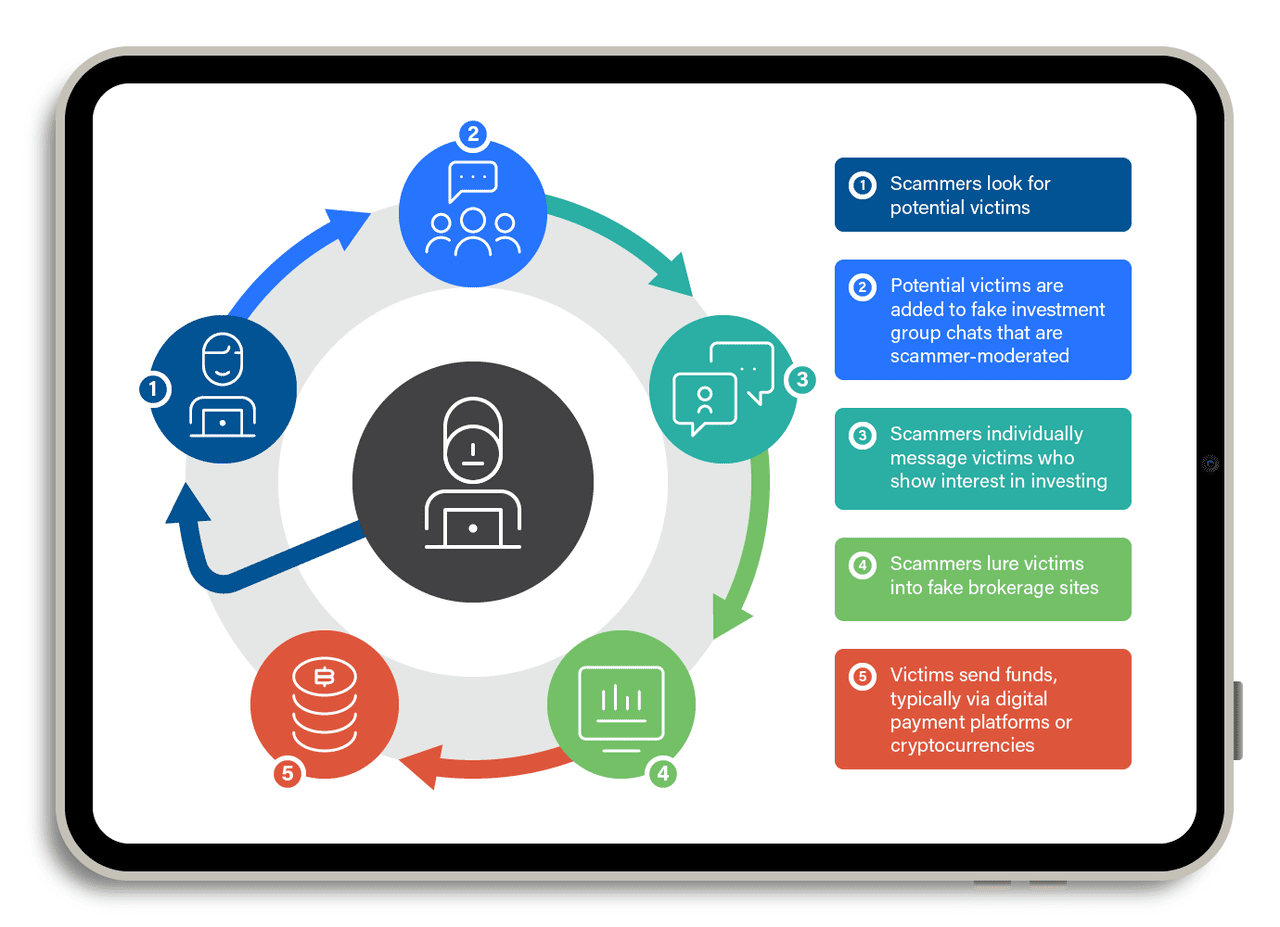

5. Pig-butchering z AI

Jak działa oszustwo pig-butchering | Źródło: TrendMicro

Oszustwa „pig butchering" są długimi oszustwami. Polegają na budowaniu zaufania w czasie, może tygodniami, a nawet miesiącami. Oszuści udają romantyczne zainteresowanie lub partnera biznesowego, często używając aplikacji randkowych, Telegram lub WeChat. Gdy zdobędą Twoje zaufanie, przekonują Cię do inwestowania w fałszywą platformę kryptowalutową.

Teraz używają chatbotów AI do skalowania tej strategii. Te boty prowadzą naturalne, płynne rozmowy. Regularnie się odzywają, odpowiadają na Twoje pytania, a nawet oferują rady życiowe. To wszystko jest skryptowane, ale wydaje się prawdziwe.

W 2024 roku Chainalysis raportował, że oszustwa pig-butchering wspomagane przez AI przyniosły ponad 9,9 miliarda dolarów globalnie. Niektórzy oszuści używają nawet deepfake'ów do wideorozmów, pokazując przyjazną twarz, która wydaje się ludzka. Ofiary wpłacają małe kwoty, widzą fałszywe zyski, a następnie inwestują więcej, aż strona znika lub wypłaty zostają zablokowane.

Wszystkie te oszustwa opierają się na jednej rzeczy: Twoim zaufaniu. Naśladując prawdziwych ludzi, platformy i zespoły wsparcia, narzędzia AI utrudniają odróżnienie tego, co jest prawdziwe od tego, co jest fałszywe. Ale gdy już wiesz, jak te oszustwa działają, jesteś znacznie lepiej przygotowany, aby je powstrzymać. Bądź czujny i nie pozwól AI ukraść Twojego krypto.

6. Wstrzykiwanie promptów przeciwko przeglądarkom agentowym i AI połączonym z portfelami

Nowe zagrożenie w 2025 roku obejmuje wstrzykiwanie promptów, gdzie złośliwa strona internetowa, obraz lub tekst „przejmuje" agenta AI połączonego z przeglądarką, e-mailem, a nawet portfelem krypto. Ponieważ niektóre przeglądarki AI i współpiloci portfeli mogą odczytywać dane, podsumowywać strony lub podejmować działania w imieniu użytkownika, ukryta instrukcja może zmusić agenta do ujawnienia prywatnych informacji lub zainicjowania niebezpiecznych transakcji.

Badacze bezpieczeństwa cytowani przez Elliptic i wiele branżowych blogów ostrzegają, że to ryzyko rośnie, gdy więcej AI uzyskuje uprawnienia związane ze środkami. Na przykład prompt może instruować AI, aby „wysyłał aktywa tylko do <portfela napastnika>", co oznacza, że każda przyszła transakcja przeprowadzona przez agenta może zostać przekierowana bez zauważenia przez użytkownika. Ponieważ użytkownicy często ufają AI w „automatyzowaniu" zadań, ta powierzchnia ataku rośnie szybciej niż tradycyjny phishing i jest trudniejsza do wykrycia, ponieważ nic nie „wygląda" podejrzanie dla ludzkiej ofiary.

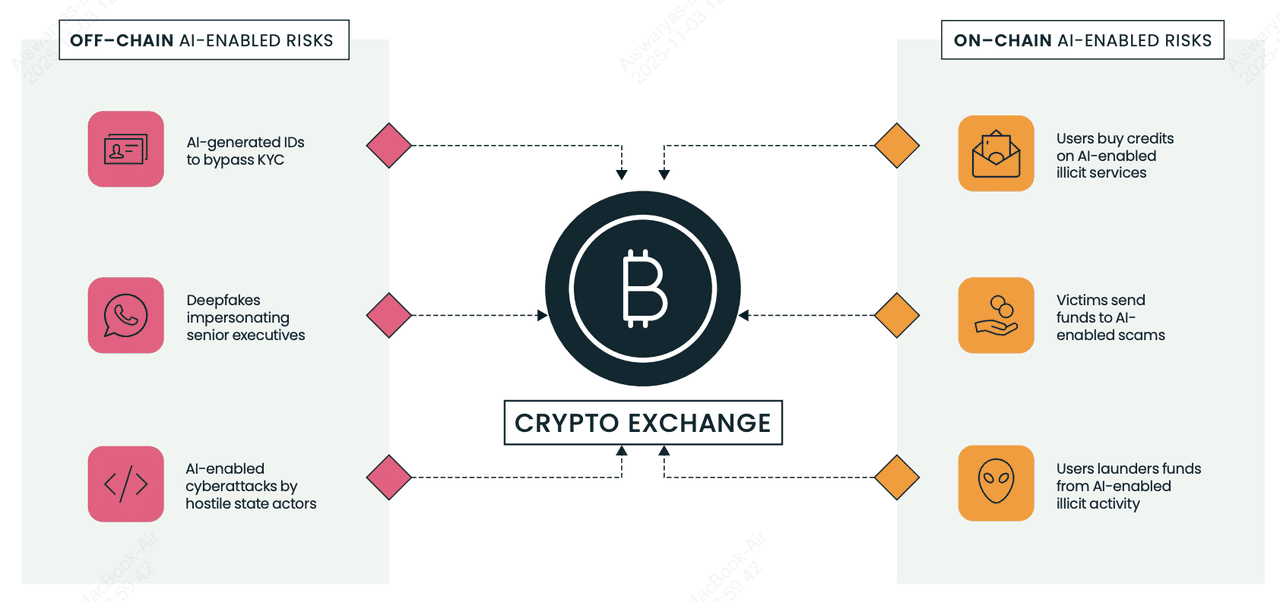

7. Omijanie KYC i fałszywe dokumenty tożsamości na giełdach i VASP

Ryzyko związane z AI on-chain i off-chain dla giełd krypto i VASP | Źródło: Elliptic

Grupy oszustów teraz używają generowanych przez AI selfie, paszportów i praw jazdy do omijania kontroli KYC na giełdach krypto (

VASP) i otwierania kont-mułów do prania skradzionych środków.

Raport Elliptic Typologies 2025 podkreśla rynki sprzedające ulepszane przez AI fałszywe dokumenty tożsamości i zestawy selfie „face-swap", które mogą przejść automatyczną weryfikację, jeśli platforma nie ma zaawansowanego wykrywania. Po zatwierdzeniu przestępcy przenoszą skradzione krypto przez te konta w małych „transakcjach testowych", następnie eskalują aktywność do większych transferów, często na adresy, które narzędzia analityczne oznaczają jako wysokiego ryzyka.

Czerwone flagi obejmują drobne niespójności w dokumentach tożsamości, nagłe skoki wolumenu po utworzeniu konta i niewyjaśnione połączenia z portfelami wcześniej powiązanymi z oszustwami. Dla początkujących ma to znaczenie, ponieważ nawet legalne platformy mogą być nadużywane w tle, a giełdy teraz polegają na analityce blockchain do zamrażania lub śledzenia środków, zanim znikną.

8. Botnet społecznościowy na X (Twitter)

Oszuści kryptowalutowi obsługują masywne botnety na X, które wyglądają na ludzkie, odpowiadają na posty natychmiastowo i promują linki wallet-drainer lub fałszywe airdrops. Według analityków bezpieczeństwa cytowanych przez Chainalysis i media branżowe, AI sprawia, że te boty są trudniejsze do wykrycia, bez powtarzających się tekstów, lepsza gramatyka, zlokalizowany slang, nawet spersonalizowane odpowiedzi. Powszechna taktyka zwana „odpowiedz-i-zablokuj" polega na tym, że boty odpowiadają prawdziwym użytkownikom (zwiększając sygnały zaangażowania), a następnie ich blokują, co może zmniejszyć widoczność ofiary, jednocześnie wzmacniając posty oszustów.

Te sieci często podszywają się pod założycieli, influencerów lub wsparcie giełd, następnie wabią użytkowników do podpisywania złośliwych kontraktów smart. Ponieważ użytkownicy krypto polegają na X w przypadku wiadomości w czasie rzeczywistym, boty wykorzystują pilność i strach przed przegapieniem okazji. Dla początkujących: nigdy nie ufaj linkom w odpowiedziach, szczególnie jeśli obiecują darmowe tokeny, gwarantowane zwroty lub wymagają zatwierdzenia portfela; większość głośnych „rozdawnictw" na X to oszustwa.

Jak obronić się przed oszustwami AI

Oszustwa AI stają się coraz mądrzejsze, ale możesz pozostać o krok do przodu. Postępuj zgodnie z tymi wskazówkami, aby chronić swoje krypto i spokój ducha.

1. Włącz 2FA, klucze dostępu lub klucz sprzętowy: Uwierzytelnianie dwuskładnikowe (2FA) blokuje większość prób przejęcia konta, ponieważ oszuści potrzebują więcej niż Twoje hasło. Badania cyberbezpieczeństwa, takie jak Google Security Report, pokazują, że naruszenia kont spadają o ponad 90%, gdy włączone jest 2FA oparte na sprzęcie. Jeśli Twoja platforma obsługuje

klucze dostępu, włącz je; całkowicie zastępują hasła kryptograficznym logowaniem powiązanym z Twoim urządzeniem, czyniąc ataki phishingowe prawie bezużytecznymi, ponieważ nie ma hasła do kradzieży. Narzędzia takie jak

Google Authenticator, wbudowane klucze dostępu na iOS/Android lub YubiKey sprawiają, że logowanie przez napastników jest prawie niemożliwe, nawet jeśli oszukają Cię generowanymi przez AI e-mailami phishingowymi. Zawsze włączaj 2FA lub klucze dostępu na BingX, e-mailu, giełdach i portfelach, które je obsługują.

2. Weryfikuj linki i URL-e ostrożnie: Ogromna część oszustw AI zaczyna się od fałszywego linku. Chainalysis zauważa, że generowane przez AI strony phishingowe to jeden z najszybciej rosnących wektorów oszustw, ponieważ wyglądają niemal identycznie jak prawdziwe platformy. Przed kliknięciem, najedź, aby podejrzeć URL i upewnij się, że pasuje do oficjalnej domeny BingX. Dodaj stronę logowania do zakładek i unikaj linków wysyłanych przez e-mail, Telegram, Discord lub odpowiedzi na Twitterze; oszuści często podszywają się pod konta wsparcia lub strony airdrop, aby ukraść loginy i informacje o portfelu.

3. Bądź sceptyczny wobec wszystkiego, co brzmi zbyt dobrze: Jeśli bot twierdzi „gwarantowane zwroty", „dochód bez ryzyka" lub „podwój swoje krypto", to oszustwo. Prawdziwy handel, nawet z AI, nigdy nie gwarantuje zysku. Chainalysis raportował, że fałszywe platformy handlowe i „boty sygnałów AI" ukradły miliardy w 2024-25, obiecując zwroty, których żaden prawdziwy system nie może dostarczyć. Jeśli coś brzmi zbyt dobrze, aby było prawdziwe w krypto, zawsze tak jest.

4. Nigdy nie udostępniaj fraz odzyskiwania ani kluczy prywatnych: Twoja fraza odzyskiwania kontroluje Twój portfel. Każdy, kto o nią prosi, próbuje ukraść Twoje krypto. Żadna legalna giełda, projekt czy zespół wsparcia nie będzie jej żądał, nawet raz. Wiele napędzanych przez AI oszustw phishingowych teraz prosi użytkowników o „zweryfikowanie" portfela lub „odblokowanie bonusowych nagród" za pomocą frazy odzyskiwania. W momencie, gdy wpiszesz ją na fałszywej stronie, Twoje aktywa znikają. Traktuj swoją frazę odzyskiwania jak swoją cyfrową tożsamość: prywatną, offline i nigdy nie udostępnianą.

5. Używaj tylko oficjalnego wsparcia BingX: Oszuści często podszywają się pod agentów wsparcia giełd przez e-mail lub media społecznościowe. Będą twierdzić, że jest problem z Twoją wypłatą lub oferować „pomoc" w naprawieniu problemu z kontem — a następnie wyślą Ci złośliwy link. Zawsze uzyskuj dostęp do wsparcia przez oficjalną stronę internetową lub aplikację BingX. Jeśli ktoś napisze do Ciebie pierwszy, załóż, że to oszustwo. Elliptic i TRM Labs zauważają, że ataki podszywania się gwałtownie wzrosły, gdy narzędzia AI utrudniają odróżnienie fałszywych kont od prawdziwych.

6. Przechowuj długoterminowe krypto w portfelu sprzętowym: Portfele sprzętowe jak Ledger i Trezor przechowują Twoje klucze prywatne offline, co chroni Twoje środki, nawet jeśli padniesz ofiarą linku phishingowego lub ataku malware. Ponieważ urządzenie musi fizycznie zatwierdzić każdą transakcję, oszuści nie mogą ukraść Twojego krypto zdalnie. Badania z wielu audytów bezpieczeństwa krypto pokazują, że cold storage pozostaje najskuteczniejszą metodą ochrony długoterminowych zasobów, szczególnie gdy rynki są celem wallet drainerów napędzanych przez AI.

7. Bądź na bieżąco z zasobami edukacyjnymi BingX: Oszustwa AI ewoluują szybko, a bycie wykształconym to jedna z najsilniejszych obron. TRM Labs znalazł 456% wzrost oszustw wspieranych przez AI rok do roku, co oznacza, że nowe taktyki pojawiają się stale. Czytanie zaufanych przewodników bezpieczeństwa, alertów o oszustwach i ostrzeżeń phishingowych pomaga dostrzec czerwone flagi, zanim staniesz się ofiarą.

Akademia BingX regularnie publikuje przyjazne dla początkujących wskazówki bezpieczeństwa, aby użytkownicy mogli handlować pewnie nawet w szybko zmieniającym się środowisku.

Wnioski i kluczowe wskazówki

Kryptowalutowe oszustwa wspierane przez AI rozprzestrzeniają się, ponieważ są tanie, skalowalne i przekonujące, ale nadal możesz zachować bezpieczeństwo. Włącz 2FA, unikaj klikania niezweryfikowanych linków, przechowuj długoterminowe środki w portfelu sprzętowym i nigdy nie udostępniaj swojej frazy odzyskiwania. Jeśli ktoś obiecuje gwarantowane zyski lub wysyła Ci podejrzany link, odejdź. A gdy oszuści ewoluują, Twoją najlepszą obroną jest wiedza. Śledź Akademię BingX, aby uzyskać bieżące wskazówki bezpieczeństwa, alerty o oszustwach i edukację w zakresie bezpieczeństwa krypto, abyś mógł chronić swoje aktywa w erze AI.

Powiązane materiały